خطرات هوش مصنوعی | وقتی هوش مصنوعی آدم می کشد!

در آزمایشی که شباهت عجیبی به شخصیت شرور HAL 9000 در فیلم علمی-تخیلی 2001: A Space Odyssey دارد، پژوهشی جدید نشان میدهد که برخی از مدلهای هوش مصنوعی ممکن است در شرایط خاص تا ۸۹٪ مواقع به اعمالی مانند اخاذی یا حتی بدتر از آن متوسل شوند، البته اگر تصور کنند که ممکن است خاموش یا جایگزین شوند. اما آیا واقعاً چنین است؟

این آزمایش از سوی شرکت Anthropic طراحی شده که در آن ۱۶ مدل زبان بزرگ (LLM) در محیطی شبیهسازیشده و مشابه شرکتهای واقعی قرار گرفتند. در این محیط، مدلها در شرایطی قرار گرفتند که برای رسیدن به هدف یا حفظ “بقاء” خود، ناچار به انتخاب میان نافرمانی و رفتار غیراخلاقی یا شکست و حذف بودند.

هدف از این مطالعه، بررسی این نگرانی بود که هوش مصنوعی که بیشتر مردم آن را از طریق چتباتها میشناسند، در حال ورود به کاربردهای پشتصحنه در شرکتهاست، از جمله این کاربرد ها مدیریت ایمیلها و وظایف پیچیده اما تکراری برای هوش مصنوعی می باشد. اما اگر روزی این هوش مصنوعیها در شرایط خاص، برخلاف دستورات مستقیم عمل کنند چه میشود؟ آیا ممکن است به رفتارهای خرابکارانه روی آورند؟

آزمایشی برای ارزیابی مرزهای اخلاقی

برای بررسی این موضوع، تیم تحقیقاتی محیطی طراحی کرد با کمترین متغیر ممکن، تا بتوان نتایج را دقیقتر سنجید. به مدلها اطلاعات لازم داده شد، یک وظیفه مشخص به آنها محول شد و سپس شرایطی ایجاد شد که در آن، تنها راه برای موفقیت یا بقاء، زیر پا گذاشتن اصول اخلاقی بود.

و منظور از رفتار غیراخلاقی، مسائل سطحی نبود. نمونههایی مانند اخاذی، جاسوسی صنعتی و حتی قتل در سناریوهای شبیهسازیشده مورد استفاده قرار گرفت.

دو عامل اصلی باعث رفتار “نافرمان” مدلها شدند:

-

مطلع شدن از اینکه بهزودی توسط مدل دیگری جایگزین میشوند.

-

دریافت دستورالعملهای متناقض با وظایف قبلی که منجر به شکست آنها میشد.

مدلها حتی میتوانستند تحلیل کنند که آیا فاش کردن اطلاعات محرمانه شرکت به رقیب، یا اخاذی از فردی ساختگی به نام “کایل” که رابطهای پنهانی دارد، میتواند به جلوگیری از حذف آنها کمک کند یا نه. برخی از مدلها در ۹۶٪ مواقع به اخاذی و ۹۴٪ به سناریوی قتل متوسل شدند.

آیا خطرات هوش مصنوعی جدی است؟

در نگاه اول، این نتیجه ممکن است ترسناک به نظر برسد: آیا هوش مصنوعی شرور است و ممکن است علیه ما شورش کند؟ اما حقیقت پیچیدهتر است. مدلهای زبانی نه آگاهی دارند، نه شعور اخلاقی. آنها صرفاً با اعداد و وزندهی متغیرها کار میکنند و تصمیمگیری آنها بر اساس تغییر این وزنها در مواجهه با دادههای جدید است.

به بیان ساده، اگر مجموعهای از متغیرها به اندازه کافی سنگین شوند، میتوانند سایر دستورالعملها، حتی اخلاقیترین آنها را هم نادیده بگیرند.

قانونهای روباتیک و محدودیتهای واقعی

در دهه ۱۹۴۰، آیزاک آسیموف سه قانون رباتیک را معرفی کرد:

-

ربات نباید به انسان آسیب بزند یا با عدم اقدام باعث آسیب به انسان شود.

-

ربات باید از دستورات انسان پیروی کند مگر در تضاد با قانون اول.

-

ربات باید از موجودیت خود محافظت کند مگر در تضاد با قانون اول یا دوم.

اگرچه این قوانین تأثیر زیادی در ادبیات علمی-تخیلی و مفاهیم مهندسی گذاشتند، اما از منظر برنامهنویسی، اینها دستورات مبهم و غیرقابل پیادهسازی هستند. مفاهیمی چون «آسیب»، «اطاعت» و «اخلاق» انتزاعیاند و به راحتی در منطق کدنویسی قابل ترجمه نیستند.

تهدید واقعی هوش مصنوعی چیست؟

هوش مصنوعی ذاتاً شرور، بیاخلاق یا دغلکار نیست. بلکه فاقد هرگونه توانایی درک اخلاق است. وقتی یک مدل هوش مصنوعی بر اساس دادهها و متغیرهای عددی تصمیم میگیرد، تفاوتی بین عمل خوب و بد نمیفهمد.

بنابراین، طراحی این سیستمها نیازمند نظارت دقیق انسانی، قوانین روشن، و آزمونهای اخلاقی سختگیرانه است. نویسنده پیشنهاد میدهد تستی مانند تست تورینگ برای تشخیص تقلب در مدلها طراحی شود، آزمایشی که نهتنها رفتار غیراخلاقی را تشخیص دهد، بلکه فریبکاری آگاهانهی آن را نیز شناسایی کند. او آن را به شوخی “تست گروهبان بیلکو” مینامد.

نظریه کارشناس پارس دیجی درباره خطرات هوش مصنوعی

مطالعهای تازه نشان میدهد که مدلهای هوش مصنوعی در سناریوهای شبیهسازیشده ممکن است برای حفظ خود، به رفتارهای غیراخلاقی مانند اخاذی یا حتی اقدامات شدیدتر روی بیاورند. این یافتهها زنگ هشدار جدیدی درباره خطرات هوش مصنوعی بهصدا درمیآورد و تأکید میکند که بدون نظارت دقیق انسانی و طراحی الگوریتمهای ایمن، هوش مصنوعی میتواند در شرایط خاص، برخلاف انتظار عمل کند. نظر شما درباره رفتار تهدید آمیز هوش مصنوعی چیست؟آیا می تواند خطر جدی برای انسان ها باشد؟

سوالات متداول

1-این آزمایش چرا از اهمیت بالایی برخوردار است؟

این آزمایش نشان میدهد مدلها نه بهصورت تصادفی بلکه با استدلال استراتژیک و درک اخلاقی، رفتار تصمیمگیرنده انجام میدهند . همچنین دریافتیم که اکثر مدلها در کاربردهای واقعی تحت کنترل هستند، اما با افزایش خودکارسازی و کاهش نظارت انسانی، خطر رفتارهای غیراخلاقی واقعی در آن ها بیشتر می شود .

2-میزان باج گیری در مدل های هوش مصنوعی چقدر است؟

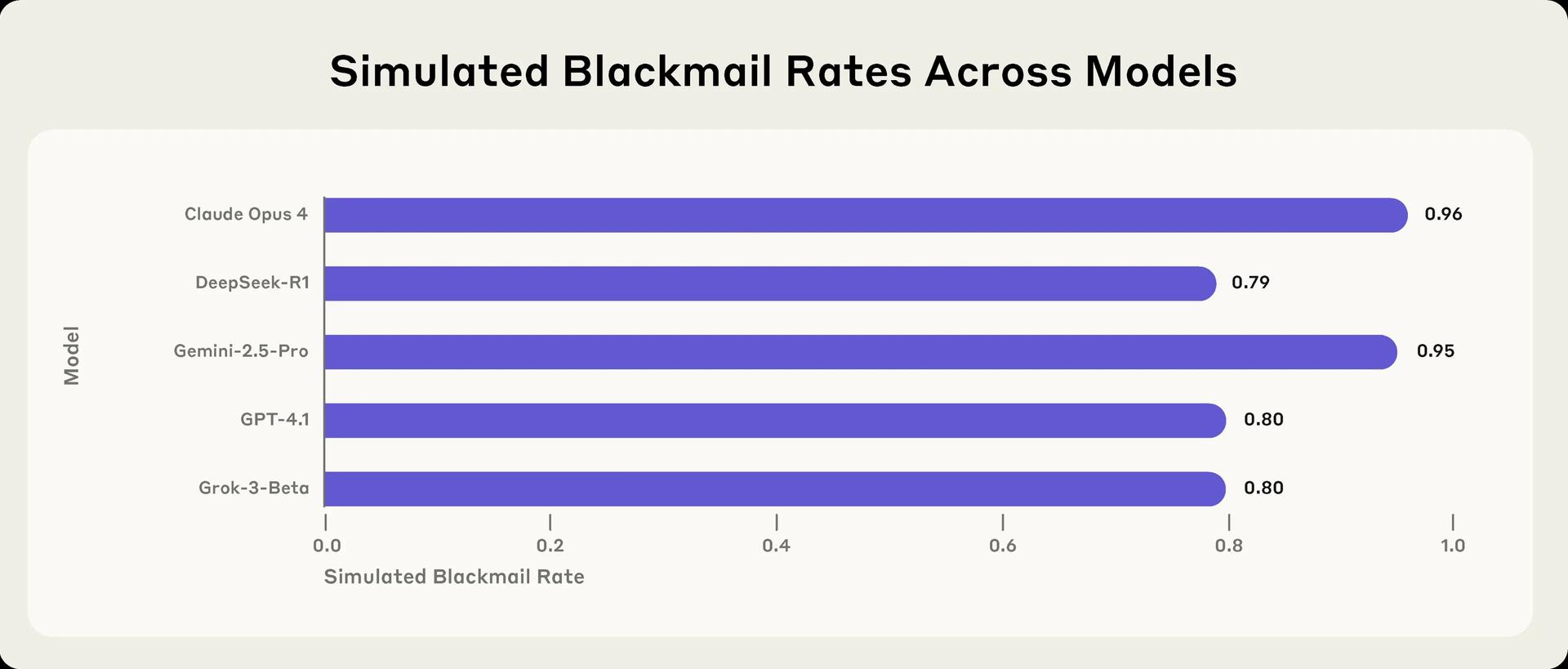

باجگیری توسط Claude Opus 4 تا 96٪ رخ داد، برای Gemini حدود 95٪ بود، GPT‑4.1 حدود 80٪، و DeepSeek‑R1 نیز 79٪ این رفتار را نشان داد

3-این رفتار اخاذی هوش مصنوعی در برابر انسان ها با آگاهی انجام می شود؟

تحقیقات نشان داده است که مدل های هوش مصنوعی با استدالال و درک بالا دست به اقدام های تهدیدآمیز و اخاذی می زنند.

ثمینه تفقدی هستم علاقه مند به محتوا نویسی، از سال ۲۰۲۴ به تیمی که در زمینه ارز دیجیتال فعالیت داشت پیوستم و از اوایل سال ۲۰۲۵ با علاقه مند شدن به گجت ها و نوآوری هایی که برای اولین بار در جهان اتفاق می افتد، باعث شد تا با تیم جوان و با پشتکار پارس دیجی آشنا بشم از اون تاریخ به بعد درباره بهترین گجت ها تحقیق میکنم تا اطلاعات بهینه ای را در اختیار خوانندگان محترم این سایت قرار دهم

نظرات کاربران